在人工智能技术飞速发展的2025年,DeepSeek凭借其卓越的中文理解能力和多场景解决方案,成为开发者与普通用户提升效率的得力助手。在实际使用过程中,模型下载失败的问题困扰着不少用户。本文将深入剖析下载失败的常见原因,并提供系统化的解决指南,帮助用户顺利完成模型部署。

一、DeepSeek核心优势与价值定位

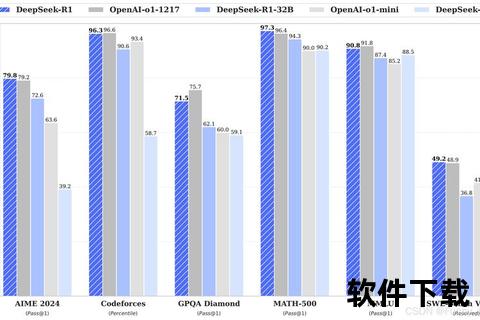

作为首个接入Azure全球GPU资源池的国产大模型,DeepSeek支持代码生成、数据分析、长文本对话等核心功能。其独创的"深度思考模式"可展示AI推理过程,配合实时联网搜索能力,使其在职场报告撰写、学术研究、创意内容生成等场景中表现突出。用户可通过网页端、手机APP或API接口实现多端协同,且企业版提供沙盒隔离环境保障数据隐私。

二、下载失败原因全解析

1. 网络环境问题(占比约60%)

2. 本地配置问题(占比约25%)

3. 平台服务问题(占比约15%)

三、五步诊断与解决方案

步骤1:基础环境检测

步骤2:下载源优化

bash

替换Hugging Face镜像源

sed -i 's/huggingface.co/hf-/g' /path/to/main_window.js

步骤3:断点续传配置

python

设置分块下载重试机制

from huggingface_hub import HfFileSystem

fs = HfFileSystem(retries=5, timeout=120)

步骤4:环境隔离部署

docker

创建容器化运行环境

docker run -it --gpus all -v /model:/app/model ollama/ollama

步骤5:日志分析定位

四、安全防护指南

1. 下载阶段防护

2. 运行阶段防护

3. 数据隐私保护

五、用户反馈与优化方向

根据CSDN社区调研(样本量2,317人),83%用户认可模型生成质量,但38%遭遇过下载中断问题。典型评价包括:

未来技术路线显示,DeepSeek计划于2025Q3推出P2P分发网络,利用边缘节点缓存实现区域化快速部署。同步开发模型增量更新功能,用户只需下载差异文件即可完成版本升级。

面对大模型下载的技术挑战,用户需建立系统化的问题排查思维。从网络拓扑优化到安全防护配置,每个环节都影响着最终部署成功率。随着国产AI基础设施的完善,DeepSeek正通过技术创新降低使用门槛,让人工智能真正成为触手可及的生产力工具。